Volver a Notas Cortas

Volver a Notas Cortas

Por Centro de Cultura Digital /

10 abr 2017

Uno de los puntos fundamentales en torno a la discusión sobre inteligencia artificial, algoritmos generativos y big data es el dejar atrás las nociones distópicas de la ciencia ficción. La visión popular y simplista de skynet—una visión que ha sido fomentada en películas como Terminator (1984), cuando las computadoras lleguen a alcanzar cierto grado de inteligencia e independencia y se rebelan contra sus inventores, los humanos, procurando su exterminio. Esta visión es producto de la falta de entendimiento del funcionamiento de las computadoras, de las limitaciones de los programas y la dependencia de las máquinas de sus operadores: los humanos. El término machine learning (llamado en español aprendizaje de máquinas o automático) es un método de procesamiento de información que se usa en áreas de investigación tan diversas como la física, la química o la sociología pero también en temas culturales, la literatura o la música. Debido a que los procesos donde machine learning se usa van más allá de la eficiencia y análisis, pueden incluso abarcar la inteligencia, la creatividad y la cultura. La revisión de esta intersección es el motivo de las no +conferencias conocidas como VOR.

El uso semántico de la inteligencia artificial

Los nuevos métodos de procesamiento masivo de información permiten a las computadoras desarrollar correlaciones inesperadas entre los datos ha llevado a revolucionar ciencias exactas como la física, y representan al mismo tiempo, una nueva manera para desarrollar herramientas y dispositivos más precisos y eficientes. Tal es el caso del trabajo de Mark Riedl director del Entertainment Intelligence Laboratory, quien diseña métodos con los que las computadoras reconocen información semántica, o para ser más preciso, puedan leer letras, cosa que ha sido un gran reto para las inteligencias artificiales hasta el momento. Riedl comenta: “la inteligencia artificial puede volverse un compañero más que una herramienta técnica”, y que “estamos en una época donde veremos cómo se convierte algo cotidiano”.

En muchos sentidos, la inteligencia artificial todavía está en ciernes. Casos como la aplicación de estos métodos de reconocimiento de voz o las capacidades para que las computadoras entablen diálogos con los humanos sin evidenciar que son máquinas, es uno de los grandes retos de los rubros de big data.

El reconocimiento de voz es ya una experiencia cotidiana que experimentamos a través de softwares instalados en celulares o en computadoras que responden a comandos auditivos, como es el caso de Siri, o Alexa. Pensar el hecho de que las computadoras entablen y dirijan una conversación o que puedan manejar lo imprevisible de una plática es algo que aún resulta lejano. Las tecnologías del lenguaje sólo pueden remplazar algunas labores altamente rutinarias, pero el reconocimiento del habla ha logrado avances suficientes para poder desarrollar máquinas traductoras confiables, y es probable que en poco tiempo sean suficientemente capaces para requerir una modesta intervención humana en la edición. Pero por el momento, la tecnología de asistentes personales como Siri de Apple o Alexa de Amazon, es usada sólo por una tercera parte de los usuarios, mientras que más del noventa por ciento de los usuarios la han probado sin hacerla una herramienta cotidiana. Este punto pone en evidencia el hecho de que se trata de tecnologías en desarrollo exponencial, como lo sugiere Wendy Johansson, cuando evalúa las formas tradicionales de programar reconocimiento de voz y señala cómo y por qué aún son ineficientes, en cambio, módelos de programación derivados de la alimentación masiva de datos al estilo big data abren la posibiliadd de que el reconocimiento de voz tenga un crecimiento inimaginable décadas atrás.

El uso social de la inteligencia artificial

Jean Pierre Kloppers CEO de BrandsEyes sugiere que el análisis de información en redes sociales enfocada al estudio de los sentimientos humanos, bajo algoritmos específicamente desarollados para la neurociencia, representa una salida mucho más eficaz a los métodos tradicionales de las empresas dedicadas a la recolección de opiniones como las encuestas telefónicas, debido a que al recolectar la información de manera indirecta, a través de los algoritmos que buscan correlaciones entre datos generados, opiniones vertidas o hábitos personales en las redes sociales son mucho más eficientes que la manera antigua de encuestar por teléfono o el levantamiento presencial de una muestra relativa de población.

Por su parte D. Fox Harrell profesor en el laboratorio de inteligencia artificial del MIT busca desarrollar algoritmos de big data para el poder judicial de Estados Unidos, que no presenten prejuicios raciales o económicos inherentes desde su programación. Fox Harrell ha desarrollado también videojuegos basados en texto y que tocan temas como la opresión, la discriminación y la libertad.

El uso cultural de la inteligencia artificial

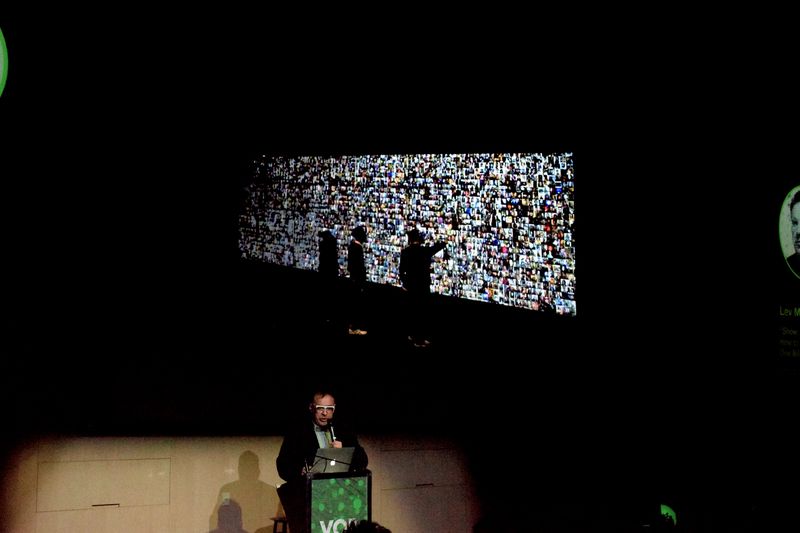

Lev Manovich es uno de los más importantes teóricos de las nuevos medios. Autor de varios los libros fundamentales para entender las tecnologías y las computadoras como es el caso de El lenguaje de los nuevos medios, y Software takes command. Manovich encarna este precepto de que la teoría es praxis, y esto es tangible en su proyecto colectivo llamado selfiecity.net, una página que permite visualizar una gran cantidad de autorretratos de personas de todo el mundo (la selfie como gesto contemporáneo) que con tecnología de reconocimiento facial cataloga las imágenes generadas en diferentes ciudades del planeta. selfiecity.net demuestra que la inteligencia artificial y el big data abren la posibilidad de estudiar productos culturales, y encontrar información que arrojan diferencias significativas entre las poblaciones de las diferentes urbes en oposición a la idea de un mundo que se asume globalizado y estandarizado.

Blaise Agüera y Arcas, uno de los principales científicos de Google, en su intervención en analizó, desde la filosofía y la arqueología de medios, el proyecto de big data y las implicaciones que tienen los algoritmos generativos y la inteligencia artificial, advirtiendo que muchos de las aplicaciones que se están desarrollando suelen tener implicaciones éticas y políticas que la filosofía del siglo XX había advertido como problemáticas, como el caso del reconocimiento facial para predecir entre grandes poblaciones posibles criminales, lo que se asemeja a comportamientos pseudocientíficos del siglo XIX como la frenología.

Corolario

Al hablar de big data, inteligencia artificial y algoritmos pensados desde la neurociencias, somos testigos de dilemas éticos que, en algún momento creímos haber superado. El brote de nuevos racismos acendrados por ejemplo se parece más a las sociedades distópicas imaginadas por la ciencia ficción que al futuro idealista imaginado por los entusiastas innovadores del siglo XX. Lo que es claro es la necesidad de recurrir a las herramientas que ofrece la filosofía para traer reflexión y pensamiento crítico a estas temáticas que nos aproximan a otro momento de las tecnologías.