Volver a Notas Cortas

Volver a Notas Cortas

Por Centro de Cultura Digital /

5 jul 2018

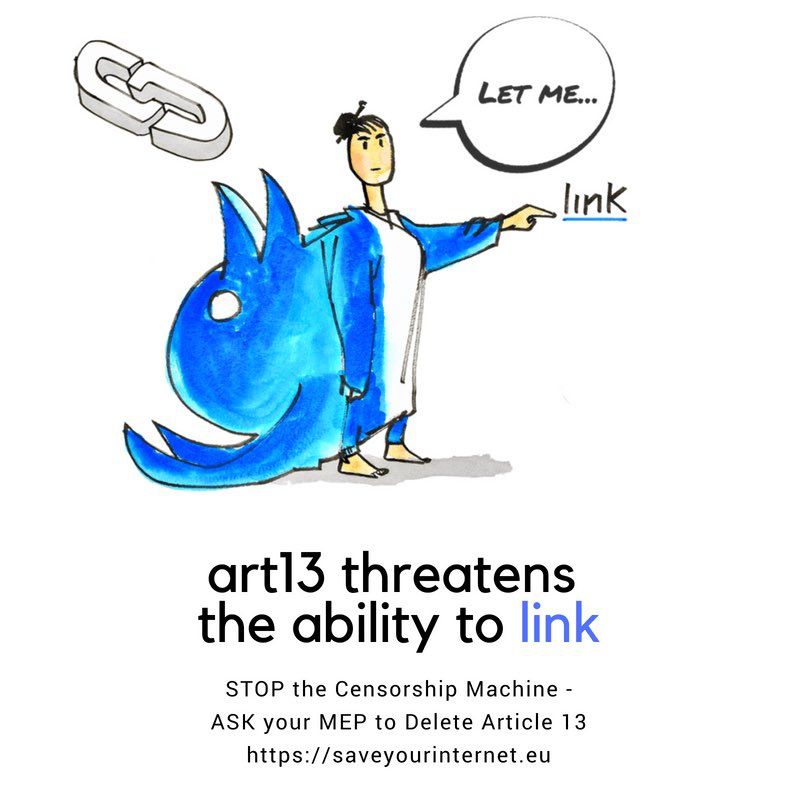

Durante los últimos meses se ha dado un debate popular en contra de la nueva Directiva del Parlamento Europeo y del Consejo sobre los derechos de autor en el mercado único digital la cual generó movilizaciones públicas y virtuales bajo el hastag: #SaveYourInternet, #LinkTax y #LeaveTheMemes. La discusión sobre esta directiva trae consigo implicaciones sobre la libertad de expresión, el acceso a la información y el conocimiento, así como sobre la neutralidad de la red. Nos parece importante tener en mente lo que se disputa en la Directiva. Tanto a nivel de las nuevas leyes de telecomunicaciones que se implementen en el continente americano, como la idea de resolver muchos de los problemas de internet a partir de la implementación de modelos computacionales (algoritmos de machine learning y otros) que en teoría estarían diseñados para defender los derechos de autor pero en la práctica se asemejan mucho a los sistemas de monitoreo de navegación, así como el uso de los datos personales de los usuarios en beneficio de entidades públicas y privadas.

La polémica en contra de la nueva Directiva europea se centra en dos artículos, el artículo 11, conocido como #linktax, que le da el poder a los grandes consorcios de información de controlar la circulación de sus contentidos en otros medios o plataformas, con el fin de resguardar el derecho de autor, para negarle a terceros citar, reproducir e incluso vincular por medio de un hipervínculo sus contenidos. Sobre este artículo, el abogado Carlos Sánchez-Almeida escribe: "Es una medida que si unimos con el artículo 13 puede ser peligrosísima para todos. Imagina que tenemos un robot que rastrea todos los contenidos de la red y encuentra textos citados de medios. Además de censurar ese contenido por derechos de autor, el dueño del texto podría denunciar a la persona que lo publicaba y exigir que le pague por ello".

El artículo 13 es el que más polémica ha causado ya que pide a los prestadores de servicio de internet, así como los grandes repositorios de diferentes medios, usen “técnicas efectivas de reconocimiento de contenidos” para buscar violaciones a la propiedad intelectual o copyright en los archivos almacenados en sus servidores así como los archivos nuevos que los usuarios se suban a sus plataformas. Para Allison Davenport (Fundación Wikimedia) y Anna Mazgal (Wikimedia Alemania) el artículo puede explicarse así: “Esta directiva requeriría que los sitios web con grandes cantidades de contenido subido por su comunidad deban implementar filtros obligatorios. Lo que esto significa es que se requerirá a los sitios web que tengan algoritmos para comprobar todas y cada una de las subidas de su comunidad, las comparen con una base de datos de contenido y que bloqueen aquellas detectadas como infractoras del copyright para que no aparezcan en línea.”

Varias de las implicaciones de la directiva significan que, en lugar de acudir a un juez para bajar contenidos ilegales en alguna plataforma, las páginas de internet impidan la publicación cualquier contenido sospechosos de inflingir algún tipo de norma. El usuario, en cambio, tendría que recurrir a los jueces para demostrar que su contenido es legal. Convirtiendo a los prestadores de servicio en los jueces sobre la legalidad de los contenidos.

En cierta medida, la directiva es una evidencia de la “confianza cada vez mayor en la tecnología para tomar decisiones sobre la legalidad del contenido en línea.” Sustituyendo labores comunitarias por la automatización y los algoritmos, que en muchos de los casos analizados (como la propia experiencia de Wikipedia con herramientas automatizadas para detectar nuevos contenidos) representa una fuerte limitante a cualquier actividad, legal o ilegal, en internet.

Davenport y Mazgal comentan al respecto: “La creencia en la inteligencia artificial y la detección automática de contenido obligatoria es insuficiente cuando presenta a la tecnología como la única solución a los problemas y retos a los que se enfrentan las plataformas online hoy en día. No es ni la mejor ni la única forma de lidiar con contenido ilegal, y mucho menos con contenido que controvertido o problemático en otros aspectos.”

La preocupación de estos modelos automatizados de detención de contenido, que se presentan en plataformas como Facebook (el caso de los pezones en esta plataforma es famoso): “Los filtros de carga tal y como existen hoy en día ven el contenido a través de una lente muy amplia, que puede pasar por alto muchos de los matices cruciales para la revisión de contenido y las evaluaciones de legalidad o veracidad del mismo. Incluso cuando se realizan mejoras en estas tecnologías (como el sistema Content ID de YouTube para identificar obras protegidas por derechos de autor y la API Cloud Vision de Google que detecta contenido “inapropiado”) estas cuestan una cantidad significativa de dinero y, a menudo, dan falsos positivos al no tener en cuenta el contexto o matices en la ley como el uso legítimo o las excepciones de los derechos de autor. Si bien se pueden hacer mejoras para solucionar estos problemas, también cabe destacar la necesidad de precaución cuando las tecnologías de detección automática se intentan aplicar como una solución general para contenido incluso más complicado o controvertido, como el relacionado con terrorismo o la desinformación.

czp